YOLO视觉检测应用标注篇(六)

全自动标注

上一篇,我们介绍了基于SAM2的半自动标注。

这一篇,我们将介绍基于YOLO的全自动标注

工具

工具依然是X-Anylabeling

下载等信息这里就不赘述了,有需要请看半自动标注篇。

原理

主要的原理就是需要有一个预训练的模型来进行辅助识别。

通过小批量的数据集训练得到一个best.pt的模型,用这个模型来进行大规模的图像标注。

模型准备

首先,需要有一个预训练的YOLO模型,比如yolo11n.pt或者best.pt。

然后,将其转为onnx格式

TIP

必须先安装必要的库

可能需要指定版本以避免出错

可使用以下代码:

1 | |

转换完成后将到可用于全自动标注的best.onnx模型

配置文件准备

下面,我们将准备best.yaml配置文件用于全自动标注

请参考下面的示例:

1 | |

也可以从X-Anylabeling的Model Zoo中下载合适的配置文件与模型。

请根据实际情况进行修改。

加载目录

模型及配置文件的放置与半自动标注那篇一样,这里不再赘述。

有需要请查看半自动标注篇。

载入模型

在X-Anylabeling中选择AI,然后加载自定义模型,在模型目录选择自定义yaml文件,就可以导入自定义的模型了

实现全自动标注

导入图片后,

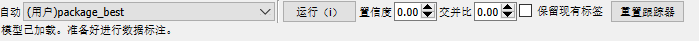

在AI设置中选择需要的置信度等参数,然后点击运行

在左侧边栏选择一次运行所有图片

确认后即完成所有图片的标注。

人工确认

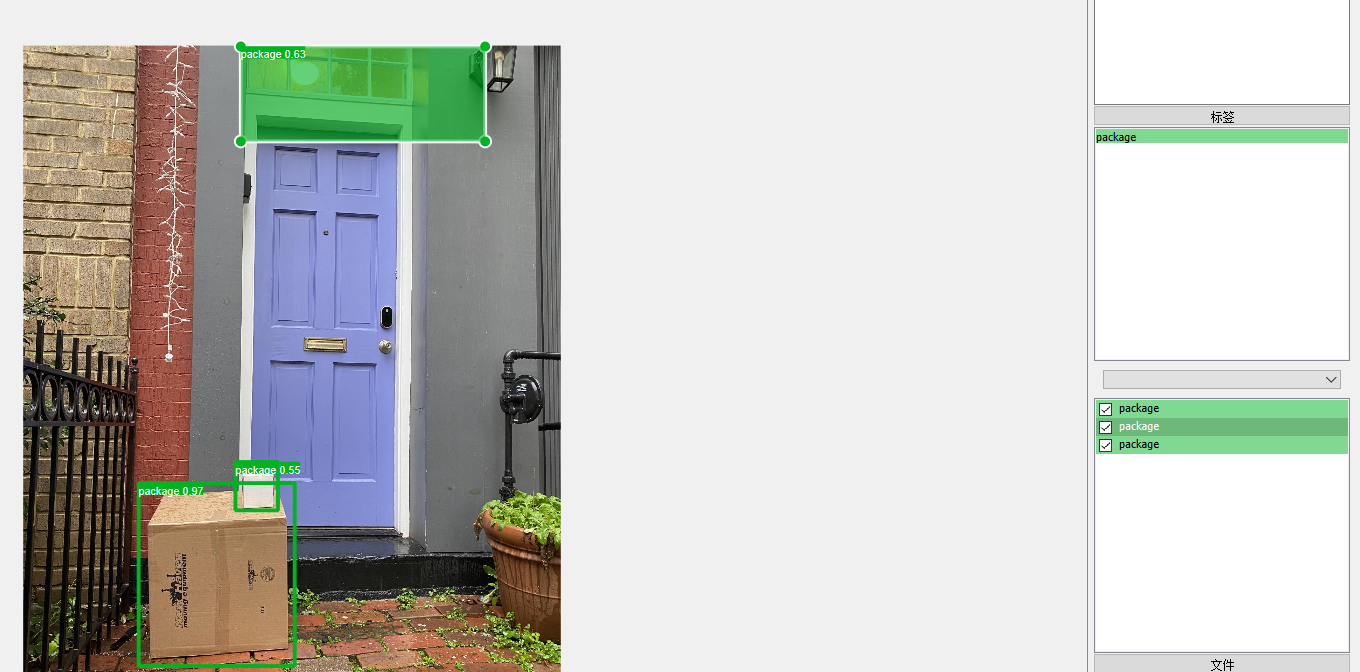

从下列的示意图我们可以看到,由于过拟合的存在,并不是package的目标物被错误标注了,我们需要进行删除

选择左侧编辑后,可以删除、拖动、放大及缩小标注矩形框,进行人工修正

人工完成所有的修正后,导出YOLO标注txt文件即完成了标注。

导出标注文件

导出标注文件与半自动标注那篇一样,这里不再赘述。

有需要请查看半自动标注篇。

小结

至此,相信YOLO数据集的准备应该可以比较有效率地完成了。

YOLO视觉检测应用标注篇(六)

http://kevin.zone.id/2025/04/19/label3/